AI的“幻觉”之谜:企业如何让机器不说胡话?

作者:AI搜索GEO研究员阿军

2025-06-03 17:50:12

自从很多自媒体老师选择用AI写文章,润色文章时,总能得到一段逻辑严密、细节丰富的回答,事后却发现很多虚构?这种现象,正是幻。它如影随形,既是技术瓶颈,也是企业应用中的潜在风险。如何去找出它们,如何应对是未来产品和企业都要面临的问题。

一、幻觉从何而来?技术原罪

1、统计预测的本质缺陷

AI大模型并非“理解”问题,而是通过海量数据训练,学习词语间的统计关联性。其核心任务是根据上文预测“最可能出现的下一个词”,而非逻辑推理或事实核查。这种模式如同“随机鹦鹉”,擅长模仿语言规律,却无法辨别真伪

。当遇到知识盲区时,模型会基于概率拼凑“合理答案”,导致虚构细节或捏造事实。

2、数据缺陷的连锁反应

训练数据的质量与覆盖度直接决定幻觉概率。若数据包含错误、过时信息,或缺乏特定领域知识,模型可能继承偏见或编造内容。这个要看语料投喂的基层知识库有多少的容量。

3、设计导向的矛盾

为追求用户体验,模型被优化为优先输出流畅回答,而非承认不确定性。当问题超出能力边界时,AI倾向于“编造”而不是回答“我不知道”

二、机制透视:幻觉如何被“触发”?

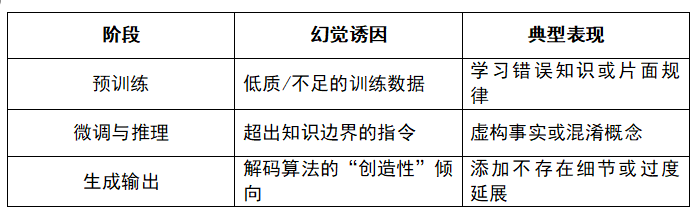

从技术流程看,幻觉贯穿AI生成的三个阶段:

尤其在高复杂度任务中(如文献综述、市场预测),模型因上下文窗口有限,可能忽略关键信息或错误关联碎片,生成“逻辑自洽的谎言”。

三、企业应对指南

1、输入优化:用精准提问“锁住”AI

设定明确边界:限定回答范围(如“仅基于2024年政策文件分析”)

拆解复杂问题:分步骤要求先列事实、再作分析

强制标注不确定性:指令如“对推测内容需标注‘可能’或‘未验证’”

2、模型调参:抑制“信马由缰”的冲动

降低Temperature参数(接近0时创造性减弱,幻觉减少)

启用事实一致性检测功能(如SAFE工具)

本地化部署时,定制知识边界规则

3、知识增强:给AI配一本“权威词典”

RAG(检索增强生成)技术:实时连接企业知识库或权威数据库,生成前先检索验证

动态更新机制:定期同步最新行业数据与政策,避免知识滞后

多模型交叉验证:聚合多个AI的答案比对差异(如DeepSeek+通义千问协同)

AI素养培训:培养批判性使用习惯,避免盲目采信

关键提示:企业需根据场景容忍度制定策略。创意策划可保留一定幻觉激发灵感;而合同审核需追求“零幻觉”。

4、在创造力与真实性间找平衡

完全消除幻觉仍是技术难题,因其与AI的创造力同源。但通过“知识约束+人类监督+人工干预”多轨制,企业完全能将其控制在安全阈值内。

当机器学会“想象”,人类更需学会“质疑”。与其恐惧幻觉,不如构建人机协同的防火墙——让AI的创造力为业务赋能,而非让虚构颠覆真实。这条路虽长,却值得每一家企业躬身入局。这就是每个企业未来要面临的统一命题。